科技工作者之家

科技工作者之家APP是专注科技人才,知识分享与人才交流的服务平台。

科技工作者之家 2018-03-23

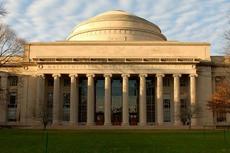

据美国科技日报网3月21日消息称,美国麻省理工学院(MIT)官方发文公布了一款新型成像系统,该系统是其媒体实验室(Media Lab)旗下摄影文化小组(Camera Culture Group)开发出的,可在人类视觉无法穿透的浓雾中测量物体距离。这一技术或将成为人类在全自动无人驾驶汽车研发道路上迈出的关键一步。

一直以来,浓雾下视线模糊的问题深深地困扰着汽车工程师们——这也是以可见光为导向的无人驾驶自主导航系统的主要技术障碍之一。

在浓雾中,人类的视觉只能穿透三十六厘米,而该系统能够在五十七厘米的范围内识别并生成物体的图像,然后再测量其距离。虽然“57厘米”的距离并不是很远,但是该实验中的人造雾气要比实际情况中人类驾驶员会碰到的任何大雾密度都要浓得多;在现实世界中,典型大雾天气下的能见度大约是三十到五十米。最为关键的一点是,该系统的性能比人类视觉系统要更加优越,而其它大多数成像系统的表现都与人类自身的视觉功能相去甚远。所以,即使是开发出一款能与大雾中人类驾驶能力相当的导航系统,也都算是一个巨大的技术突破。

“我们的研究针对的是真实情况中的雾——密集的、动态的,而且其成分是多样的。它始终处于不断的移动和变化中,并且,有的部分稠密,有的部分密度相对较低。之前其它的一些技术方法并不是专门为了应付这种现实情况而设计的。”麻省理工学院媒体实验室的研究生盖伊·萨特(Guy Satat)解释道。萨特和同事将在五月举行的“国际计算摄影大会”(International Conference on Computational Photography)上宣讲一篇描述该研究成果的论文,他是该文的第一作者,其他的作者还包括他的导师、媒体艺术与科学副教授拉梅什·拉斯卡尔(Ramesh Raskar)和研究生马修·坦西克(Matthew Tancik)。

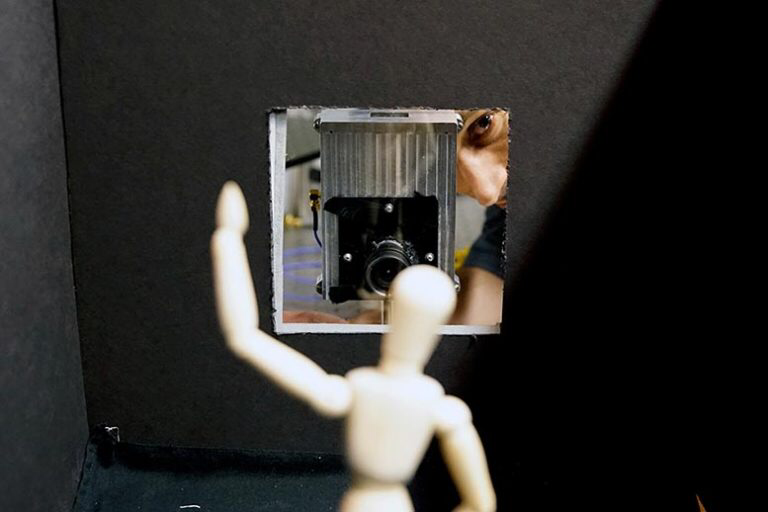

与摄影文化小组的许多其它研究项目一样,该新系统也采用了可测深度摄像头(TOF Camera),该设备可以将波长超短的激光束射入前面的场景中,然后在通过测量其反射回来的时间来确定物体的距离。

这一新系统通过整合统计数据解决了大雾中可见光不均衡和不稳定的问题。雾中反射光所产生的数据模式会跟随雾密度的变化而变化;平均来说,光线穿透浓雾的距离要比在薄雾中的距离更短。然而,麻省理工的研究人员成功证明了,无论雾有多厚,反射光到达摄像头的时间都遵循一种称为“伽马分布”(gamma distribution)的统计模式。

像高斯分布一样,该统计模式也是由两个变量所决定的。该系统会对空气中的这些变量进行即时预估,并利用由此产生的数据分布来过滤交通信号之外的雾反射。最为重要的一个技术细节是,该系统能为传感器中1024个像素中的每一个像素计算出不同的伽马分布。这也就是为什么它能够应对之前的其它系统所不能处理的雾密度的变化——它能够把每个像素都看作是不同类型的雾,然后根据每种情况进行反应。

“恶劣天气是自动驾驶技术面临的最大障碍之一。”美国卡内基梅隆大学计算机科学教授斯里尼瓦萨·纳拉辛汗(Srinivasa Narasimhan)指出,“盖伊和拉梅什的创新成果是我在可见光或近红外波段领域内,所看到的对于可视性提升效果最佳的研究案例,很有可能不久之后,这一技术就能应用于自动驾驶汽车。”

科界原创

编译:朱明逸 审稿:西莫 编辑:张梦

来源:https://scitechdaily.com/depth-sensing-imaging-system-can-see-through-fog/

变废为宝!新技术可将碳排放转化为燃料

麻省理工学院科学家开发智能电源插座

金属3D打印即将成为现实

麻省理工学院创造出可以实现排汗的智能皮肤

“旧瓶装新酒”?DARPA重金资助发展单片3D集成技术,90纳米工艺造芯片有望打败7纳米工艺造芯片

CICC科普栏目|麻省理工学院的牛人解说数学体系,你到哪个层次了?

MIT投资10亿美元开设AI学院:推进AI在各学科应用

麻省理工学院的“间接照明”

MIT|2021 Blended Learning麻省理工学院官方课程项目公开课预告

经济学家揭示:你的行为习惯而非理智主导着你的消费