科技工作者之家

科技工作者之家APP是专注科技人才,知识分享与人才交流的服务平台。

科技工作者之家 2019-10-17

人们通常认为,随着人工智能(AI)系统变得越来越复杂,它会变得越来越不容易解释。但是研究人员已经开始通过像Facebook的模型可解释库Captum来挑战这一观念。Captum利用深度学习框架PyTorch、IBM的AI Explainability 360工具包以及微软的InterpreacML,解释神经网络如何做出决定。

为了让AI的决策过程变得更加透明,来自谷歌和斯坦福的联合研究团队最近探索了一种机器学习模型,即基于概念的自动解释模型(ACE),它会自动提取“具有人类直觉意义”的视觉概念,并为模型的预测提供信息支持。

正如研究人员在详述他们发现的论文中所解释的那样,大多数机器学习解释方法都会改变单个特征(例如,像素、超像素或词向量等),以使每个特征达到近似目标模型重要性的水平。这是一种不完美的方法,因为它很容易受到输入中哪怕是最小变量的影响。

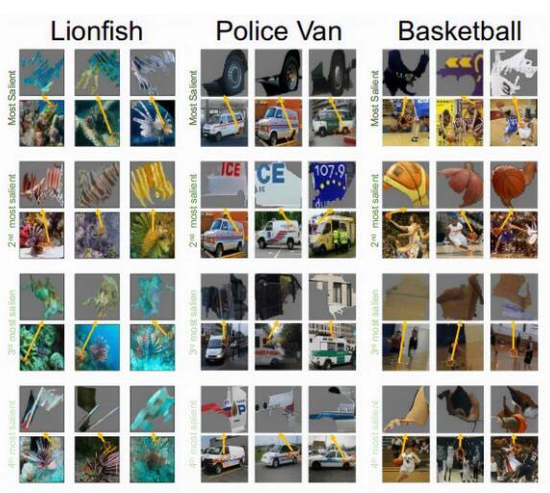

相比之下,ACE通过在提取概念并确定每个概念的重要性之前,将训练有素的分类器和属于该类别的一组图像作为输入来识别较高级别的概念。具体地说,ACE使用多个分辨率对图像进行分段,以捕获几个层次的纹理、目标部分和目标整体,然后将相似的分段作为相同概念的示例进行分组,并返回最重要的概念。

为了测试ACE的表现,研究团队使用了谷歌的Inception-V3图像分类器模型,该模型是在流行的ImageNet数据集上训练的,并从数据集中的1000个类别中选择了100个子集来应用ACE。他们指出,被标记为重要的概念往往遵循人类的直觉。例如,在探测警车时,执法部门的标志显然比地面上的沥青更重要。

然而,情况也并不总是这样。在不太明显的例子中,分类篮球图像的最重要概念是球员的球衣而不是篮球本身。当涉及到旋转木马的分类时,灯光比显然座位和支撑架更重要。

研究人员承认,ACE绝不是完美的,尽管它在努力以有意义地方式提取异常复杂或困难的概念。但他们相信,这种方法为模型学习相关性提供了洞察力,可能会促进更安全地使用机器学习技术。

研究人员写道:“我们通过人体实验验证了ACE的意义和连贯性,并进一步验证了它们确实携带用于预测的显著信号。我们的方法可以自动将输入的特征分类为高级概念,并将有意义的概念作为连贯的示例显现出来,这对于正确预测它们所在的图像非常重要。我们发现的概念显示,模型能够令人惊讶的学会理解潜在相关性。”(选自:VentureBeat 作者:Kyle Wiggers 编译:网易智能 参与:小小)

来源:网易智能

大风:社会组织与公益 是解决就业和社会稳定最重要的渠道

昆山智能机器人及成套装备协会成立

兰德如何进行人工智能/机器学习兵棋推演(二)

【WRC • 资讯】谷歌云人工智能预测服务全面开通

机器学习:人工智能的三种设计模式

【WRC • 资讯】人工智能和机器学习技术推动企业发展

人工智能与量子计算携手,量子机器学习未来潜力有多大

兰德人工智能/机器学习桌面战术兵棋规则(一)

为什么说机器学习不是人工智能?

兰德如何进行人工智能/机器学习兵棋推演(一)