科技工作者之家

科界APP是专注科技人才,知识分享与人才交流的服务平台。

科技工作者之家 2019-11-06

来源:科研圈

在嘈杂的环境中准确捕捉一个人的声音,这是一项非同寻常的能力。哥伦比亚大学带领的研究团队重新审视大脑听觉中心的结构功能,为助听技术树立新路标。

图片来源:Pixabay

我们的大脑具有从众多声音中挑选出一种声音的非凡能力。现在,哥伦比亚大学(Columbia University)的一个神经科学工程师团队已经揭示了大脑让这一壮举成为可能的过程。这一发现有助于解释一个长久以来的科学问题,即听觉皮层如何以闪电般的速度在众多声音中解码并放大某一特定声音。这项新发现的知识还将促进助听器技术和模拟大脑的脑机接口技术发展。

这些新发现近期发表在《神经元》(Neuron)杂志上。

“我们可以在噪音环绕的鸡尾酒会中,专一地捕捉到身边说话人的声音,这是一种非同寻常的能力,但我们对这一运作方式了解甚少。“ Nima Mesgarani 教授说道,他是这篇论文的资深作者,也是哥伦比亚大学莫蒂默·B·扎克曼心智大脑行为研究所(Columbia's Mortimer B. Zuckerman Mind Brain Behavior Institute)大脑行为研究所的首席研究员。“如今的研究为我们做出了所需的解释,这对致力于改进语音和听力技术的科学家和创新者来说至关重要。”

听觉皮层是大脑的听觉中枢。内耳向大脑的这一区域发送代表外界声音的电信号,这些电信号包含了所有来自外部的杂乱声波。然后,听觉皮层必须从这些杂乱的声音中筛选出有意义的声音。

Mesgarani 还是哥伦比亚工程学院电气工程学副教授,他这样形容道:“研究听觉皮层如何分辨出不同的声音,就像在一个大湖中,试图仅以水中波纹的模式为线索,确定正在进行中的每条船、每名游泳者和鱼在如何移动,以及运动速度有多快。”

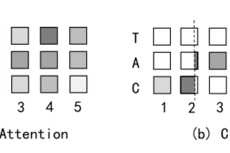

这一论文建立在该团队 2012 年的研究基础之上,该研究表明人脑对听到的声音是具有选择性的。研究表明,当一个人听某人讲话时,他们的脑电波会发生变化,以识别说话者的声音特征并屏蔽掉其他声音。研究人员们想了解这一过程对应的听觉皮层的内部活动。

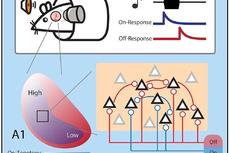

大脑在面对多个发言者时的示意图。图片来源:哥伦比亚大学祖克曼研究所

大脑在面对多个发言者时的示意图。图片来源:哥伦比亚大学祖克曼研究所

“我们很早就知道听觉皮层的区域是按等级分布的,随之递增的是越来越复杂的解码过程,但我们还没有观察过特定说话者的声音是如何经过这一路径被逐级处理的。”James O'Sullivan 指出,“为了解这一过程,我们需要直接记录大脑的神经活动。”他是论文的第一作者,曾在 Mesgarani 教授实验室担任博士后研究员时完成了这项工作。

研究人员对听觉皮层分级结构中的两个部分尤其感兴趣:海氏回(Heschl’s gyrus,HG)和颞上回(STG)。通过耳朵传达的信息首先到达 HG,经过它到达 STG 。

为了解这些大脑区域,研究人员与神经外科医师 Ashesh Mehta、Guy McKhann、Sameer Sheth、神经病学家 Catherine Schevon,以及合著者 Jose Herrero 教授和 Elliot Smith 教授组成研究团队进行合作。这些医生在哥伦比亚大学欧文医学中心(Columbia University Irving Medical Center)和诺斯维尔保健(Northwell Health)为癫痫患者提供治疗,一些患者必须定期进行脑部手术。在这项研究中,自愿参与实验的患者,在手术中听取人们说话的录音,与此同时 Mesgarani 和 O'Sullivan 通过在病人的 HG 和 STG 区域植入电极监测其脑电波。

这些电极可以帮研究人员明确区分开这两个区域在传播声音时扮演的角色。数据表明,HG 产生了丰富的多维度的混合声音,从而每个人的声音都有特定的频率。这个区域没有表现出对某种声音的偏好。但是,从 STG 收集的数据却截然不同。

O'Sullivan 博士说:“我们发现通过适当地加强 HG 输出的信号可以放大某个人的声音。根据我们的记录显示,可能是 STG 区域执行了这种加强。”

综上所述,这些发现揭示了听觉皮层这两个区域的职责划分:HG 负责展示, STG 负责挑选。这一切都发生在大约 150 毫秒内,这对于听者而言几乎是实时发生的。

研究人员还发现了 STG 的另一个作用。STG 在选择声音后,形成了一个相应的听觉目标,作为该声音的表征——类似于我们用肉眼看到的事物的心理表征。这表明,即使一个声音被另一个声音掩盖——例如两个人同时发言的情况,STG 仍可以将目标声音划为一个统一的整体,不受另一个声音的干扰。

这些研究成果可以作为基础算法,人为复制出这一生物过程,例如在助听器技术中。今年早些时候, Mesgarani 教授和他的团队宣布他们开发了一种脑控助听器,可以利用这种算法在杂乱的声音中,放大单个人的声音。

研究人员计划在更复杂的场景中研究 HG 和 STG 的活动,比如包含更多的说话者或更多视觉提示。这些努力将有助于创建出一个详细而精确的图景,展示听觉皮层每个区域如何运作。

“我们的最终目标是更好地了解大脑让我们可以如此良好地聆听的秘诀,并创造出可以帮助人们的技术——无论是让中风幸存者可以与自己爱的人说话,还是让有听力缺陷的人可以在拥挤的聚会中更轻松地交谈” Mesgarani 教授说,“这项研究是这条道路上的一个关键点。”

论文信息

【标题】Hierarchical Encoding of Attended Auditory Objects in Multi-talker Speech Perception

【作者】James O’Sullivan et al.

【时间】21 October 2019

【期刊】Neuron

【链接】https://www.cell.com/neuron/fulltext/S0896-6273(19)30780-9

【摘要】Humans can easily focus on one speaker in a multi-talker acoustic environment, but how different areas of the human auditory cortex (AC) represent the acoustic components of mixed speech is unknown. We obtained invasive recordings from the primary and nonprimary AC in neurosurgical patients as they listened to multi-talker speech. We found that neural sites in the primary AC responded to individual speakers in the mixture and were relatively unchanged by attention. In contrast, neural sites in the nonprimary AC were less discerning of individual speakers but selectively represented the attended speaker. Moreover, the encoding of the attended speaker in the nonprimary AC was invariant to the degree of acoustic overlap with the unattended speaker. Finally, this emergent representation of attended speech in the nonprimary AC was linearly predictable from the primary AC responses. Our results reveal the neural computations underlying the hierarchical formation of auditory objects in human AC during multi-talker speech perception.

来源:keyanquan 科研圈

原文链接:http://mp.weixin.qq.com/s?__biz=MzA5NDkzNjIwMg==&mid=2651686749&idx=4&sn=395ad46f3df777f89e2d6e27ea743242&chksm=8bbe2ab8bcc9a3aebb050968a1cbb825be89c48b687c27c345162efb26c43cbe7ba8ab95aaf1&scene=27#wechat_redirect

版权声明:除非特别注明,本站所载内容来源于互联网、微信公众号等公开渠道,不代表本站观点,仅供参考、交流、公益传播之目的。转载的稿件版权归原作者或机构所有,如有侵权,请联系删除。

电话:(010)86409582

邮箱:kejie@scimall.org.cn

全球有超过15亿人听力受损,你的听力真的没问题吗?

保护听力 终生受益 | 从预防噪声性听力损失开始

别让听觉神经被噪音“谋杀”

听力下降是老年人的专利?警惕这些习惯损伤听力

听力受损有哪些表现?哪些坏习惯会损伤听力?我们又该如何保护听力呢?一起来看一下吧!

相比恒河猴,人类的听觉脑区更偏爱谐波声音 | 《自然-神经科学》

Cell Reports | 听觉皮层通过不同区域环路可并行处理声音的开始与结束

我们为什么会给动图脑补声音?

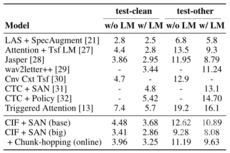

听觉模型与认知计算团队提出一种基于神经元整合发放的语音识别新机制

“这是一张有声音的gif“:我们为什么会给动图脑补配音?