科技工作者之家

科技工作者之家APP是专注科技人才,知识分享与人才交流的服务平台。

科技工作者之家 2020-11-17

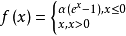

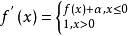

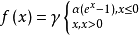

指数线性单元,该激活函数由Djork等人提出,被证实有较高的噪声鲁棒性,同时能够使得使得神经元的平均激活均值趋近为 0,同时对噪声更具有鲁棒性。由于需要计算指数,计算量较大。

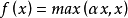

简介表达式

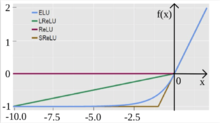

与其他激励函数对比图像

上图为ELU、LReLU、ReLU和SReLU的对比图。

类似激活函数神经网络中使用激活函数来加入非线性因素,提高模型的表达能力。Leaky ReLU、ELU及SELU均为ReLU的变种函数。

ReLURectified Linear Unit,修正线性单元,形式如下:

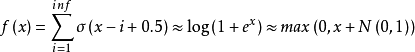

RELU公式近似推导:

RELU公式近似推导:

其中

其中 。

。

softplus函数 与ReLU函数接近,但比较平滑,同ReLU一样是单边抑制,有宽广的接受域(0,+inf), 但是由于指数运算,对数运算计算量大的原因,而不太被人使用。

与ReLU函数接近,但比较平滑,同ReLU一样是单边抑制,有宽广的接受域(0,+inf), 但是由于指数运算,对数运算计算量大的原因,而不太被人使用。

ReLU的缺点:

1.坏死: ReLU 强制的稀疏处理会减少模型的有效容量(即特征屏蔽太多,导致模型无法学习到有效特征)。由于ReLU在x

2.无负值: ReLU和sigmoid的一个相同点是结果是正值,没有负值。

Leaky ReLU当 时,

时, ,其中

,其中 非常小,这样可以避免在

非常小,这样可以避免在 时,不能够学习的情况:

时,不能够学习的情况:

称为Parametric Rectifier(PReLU),将

称为Parametric Rectifier(PReLU),将 作为可学习的参数1。

作为可学习的参数1。

当 从高斯分布中随机产生时称为Random Rectifier(RReLU);

从高斯分布中随机产生时称为Random Rectifier(RReLU);

当 时,称为Leaky ReLU。

时,称为Leaky ReLU。

优点:1.不会过拟合;2.计算简单有效;3.收敛更快。

SELUSELU是给ELU乘上系数 ,即:

,即:

本词条内容贡献者为:

王沛 - 副教授、副研究员 - 中国科学院工程热物理研究所