科技工作者之家

科技工作者之家APP是专注科技人才,知识分享与人才交流的服务平台。

科技工作者之家 2018-12-14

人工智能的“偏见”危机

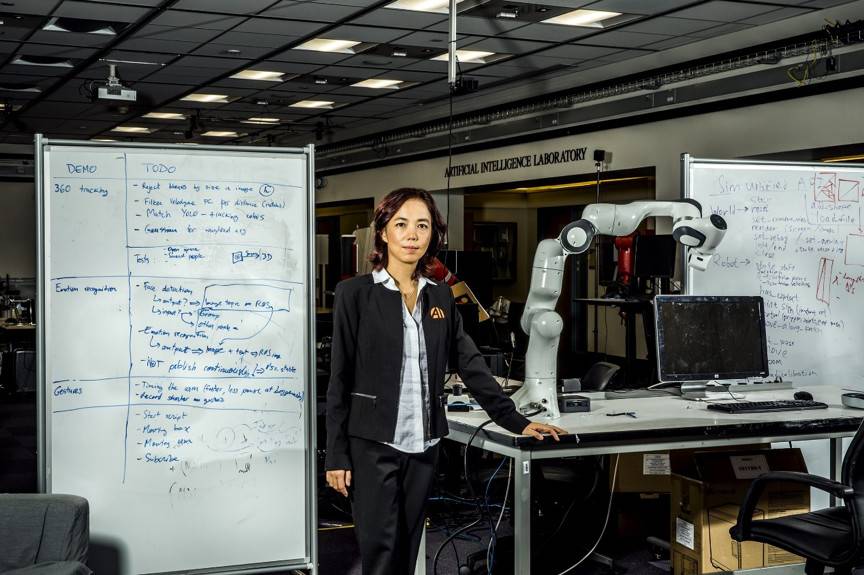

今年 6 月 26 日,李飞飞走进美国众议院科学、空间与技术委员会(the US House Committee on Science, Space, and Technology)的会议室,出席一场听证会,主题为“人工智能——力量与责任并存(Artificial Intelligence—With Great Power Comes Great Responsibility)”。她演讲的内容是人工智能带来的危机。

李飞飞是桌边唯一的女性。她参与构建的 ImageNet 数据库能够帮助计算机识别图像。有了这样的人工智能软件,计算机可以学会做某个特定的任务,用时要比人工短得多。而且,随着人工智能的复杂化,它可以代表人类对数据进行过滤、分类和分析,最后做出影响社会乃至全球的决策。现如今,人工智能可以判断该对病人处以何种治疗、谁能获得人寿保险、犯人的监禁时间要判处多长、哪些求职者能进入面试等等。

当然,如果操作不当,这些力量也可能是危险的。亚马逊的人工智能招聘软件学会了剔除那些含有“女性”字眼的简历,因此强制被停用;2015 年谷歌的照片识别软件错把黑人当成大猩猩,这一事件成为广为人知的事故;微软的社交聊天机器人发出的推文带有种族歧视,为大家所唾弃。如今我们还能找出问题出在哪,从而进行修正,但李飞飞认为,随着人工智能技术被广泛、快速纳入应用,我们在不久的将来就会到达一个时间点,无法进行自我修正。

这个领域当中绝大多数有权威的杰出男性领导者不止一次发出警告,认为人工智能驱动的技术有朝一日会对人来产生威胁。但李飞飞认为大家还不必对这些担忧太过重视。她所关心的问题没有那么宏大,却更为重要:人工智能会对人们的工作、生活方式产生怎样的影响。这项技术肯定会改变人类的生活体验,然而并不一定是向更好的方向。

李飞飞坚信人工智能领域需要一次“校正”,她说:“我们还有时间,但行动要趁早。”如果我们对人工智能的编程方式和背后的程序员进行根本上的改变,这项技术就可以极大地提高我们的生活质量。若非如此,我们中的大部分都跟不上变革的脚步。

李飞飞在听证会上最后一个发言。“人工智能并不‘人工’,”她的声音越来越洪亮,“它受到人类的启发,由人类所创造,而且最重要的是人类会受其影响。它是一种强大的工具,我们对它的理解还处在初始阶段,掌握它是我们深远的责任。”与会者们听得聚精会神。

“不可能”的数据库

李飞飞在成都长大,这是中国南方的一座工业化城市。她不爱说话,头脑聪明,还很喜欢读书。她的家庭也有点不同寻常:当时很少有人养宠物,她爸爸却给她买了只小狗。妈妈出身书香门第,鼓励她阅读《简·爱》。

李飞飞 12 岁的时候,爸爸移民到了新泽西州的帕西帕尼(Parsippany),16 岁时她和母亲也一起移民。李飞飞只用了两年时间就掌握了英语,在学校的表现也很好,1995 年拿到了普林斯顿大学的奖学金。大学期间她兴趣十分广泛,主修物理,辅修了计算器科学与工程。2000年,她到在位于帕萨迪纳(Pasadena)的加州理工学院攻读博士学位,研究神经科学和计算机科学的交叉学科。

李飞飞能找到看似不相关的领域之间的联系,并且加强这种联系,正是这种能力带给了她设计 ImageNet 的灵感。同样研究计算机视觉的人在研究帮助计算机感知和解码图像的模型,但模型应用范围有限:要识别狗得写一套程序,要识别猫还得另写一套。李飞飞开始怀疑问题出在数据而不是模型上。她认为,如果小孩可以通过观察生活中数不胜数的物体和场景,体验视觉世界,获得“看见”的能力,那么计算机或许也能通过分析各种图像及其联系,以类似的方式学习。这是李飞飞一个重要的发现。她认为:“这种方式可以组织整个世界的视觉概念。”

李飞飞 2007 年回到普林斯顿担任助理教授,这期间她提出了构建 ImageNet 的想法,但很难找到愿意帮忙的教师。她无法说服同事们,让他们相信用一个数据库来完成对每张图片、每种物体进行标记的庞大任务是可以完成的。尤其是李飞飞还决定,为了能将想法付诸实践,这些标记不能是概括性的描述(如“哺乳动物”),而必须具有高度特异性(如“星鼻鼹鼠”)。最后,一位研究计算机架构的教授终于同意与她合作。

李飞飞面临的下一个挑战就是把这个庞然大物构建出来,这就意味着得找许多人花大量的时间来给图片做标记。李飞飞曾经尝试以 10 美元一小时的报酬找普林斯顿的学生帮忙,但进展依旧十分缓慢。后来有学生向她推荐了亚马逊土耳其机器人(Mechanical Turk,亚马逊的一家网络集市,允许企业在这一平台上雇佣员工,执行简单的工作,比如在照片中识别某人的身份等)。这下她就能用很低的成本来吸引到很多工人了。

ImageNet 的诞生

2009 年,李飞飞的团队已经获得了 320 万张标记好了的图片,他们认为这么大的数量涉及内容很全面,已经足够使用了,于是他们用图片和编好的数据库一起发表了一篇论文(后来图片数量增长到 1500 万)。随后她的团队又提出了新想法:他们联系上了来年欧洲计算机视觉竞赛的组织者,希望能允许参赛选手使用 ImageNet 数据库训练他们的算法。 ImageNet 大规模视觉识别挑战赛(the ImageNet Large Scale Visual Recognition Challenge)就此诞生。同年,李飞飞加入斯坦福大学担任助理教授,与机器人学家西尔维奥·萨瓦里斯(Silvio Savarese)结婚。

2012 年,多伦多大学研究员杰弗里·辛顿(Geoffrey Hinton)参加了 ImageNet 比赛,利用该数据库训练了一种叫做深度神经网络(deep neural network)的人工智能,比之前所有的成果都准确得多,他因此获得了比赛的冠军。李飞飞本来没打算去看辛顿的比赛:她正在休产假,而颁奖典礼在意大利佛罗伦萨举行。但她意识到这是历史性的一刻,所以在最后时刻买了机票,在飞机的中间座位上挤了一夜。

辛顿获奖后不久,李飞飞开始反思自己的团队中几乎没有女性。那时她敏锐地感觉到,这种差异会越来越成问题。绝大多数写人工智能算法的科学家都是男性,而且往往是具有相似背景的男性。他们大多看着《终结者》(The Terminator)和《银翼杀手》(Blade Runner)长大,完成的项目、甚至设想的危险中无不反映着一种特殊的世界观。李飞飞认为担心这些没什么不妥,但这些担忧与人工智能可能存在威胁的狭隘观点相悖。

正如李飞飞所说,深度学习系统的“输入和输出都有偏见”。她发现虽然人工智能背后的算法有可能是公正的,输入的数据和结果的应用却并非如此。人工智能的构建者和构建的原因很重要。在国会山的会议上,李飞飞指出,如果没有多元化的工程师团队,我们就可能会用看似公正的算法通过不公正的贷款申请,或者只用白人面孔的数据训练神经网络,得到可能对黑人并不适用的模型。她说:“我认为我们若是 20 年后醒来,看到我们的技术、领导者和从业者都缺乏多样性,那将是世界末日的情形。”

李飞飞越来越觉得利用人工智能的发展改善人类的生活体验十分重要。她在斯坦福有个项目就是和医学院合作,将人工智能带进重症监护室,减少医院获得性感染。项目包括开发一种可以监控洗手台的摄像系统,在医护人员忘记正确洗手时加以提醒。类似这样的跨学科的合作很少见。斯坦福大学临床卓越研究中心的医学教授阿诺德·米尔斯坦(Arnold Milstein)说:“没有其他计算机科学系的老师找过我合作。”

这项工作让李飞飞对人工智能的改进方向有了灵感:它可以作为人类技能的补充品,而非替代品。如果工程师能和其它学科(甚至非学术界)的人多沟通,就能创造一些延伸人力的工具,比如自动完成某些耗费时间的任务,让重症监护室的护士有更多时间陪伴病人,而不是创建自助购物程序抢收银员的饭碗。

辛顿用 ImageNet 支持的神经网络做出了翻天覆地的改变。到 2017 年,也就是上一次 ImageNet 大规模视觉识别挑战赛为止,计算机识别图像中物体的错误率已经从 2012 年的 15% 下降到不足 3%。至少从这个方面来看,计算机的识别能力比人类更好。考虑到人工智能正在飞速发展,李飞飞认为她需要尽快给团队来一次换血。

举办夏令营

根据美国国家科学基金会(National Science Foundation)的统计,在 2000 年获得计算机科学学士学位的学生中,仅有 28% 是女性。2015 年这一比例为 18%。

在自己的实验室里,李飞飞也在努力招募有色人种和女性。当奥尔加·鲁萨科夫斯基(Olga Russakovsky)成为李飞飞的学生时,她正打算退出这个领域。那时鲁萨科夫斯基已经是一位熟练的计算机科学家,拥有斯坦福大学的数学学士和计算机科学硕士学位,但博士论文进展很缓慢。作为实验室中唯一的女性,她感觉和同事们有点格格不入。李飞飞来到斯坦福之后改变了一切。在她的帮助下,鲁萨科夫斯基学到了一些成功研究的技巧,“也帮我找回了自信,”鲁萨科夫斯基说,她现在成了普林斯顿大学计算机科学的助理教授。

四年前鲁萨科夫斯基做博士论文时,她向李飞飞求助,希望能帮她组建一个吸引女孩了解人工智能的夏令营。李飞飞马上同意,她们把志愿者集合起来,发布了广告,招募高二学生参加。活动只有 24 个名额,然而一个月之内她们就收到了 200 份申请。两年后她们扩展了这一项目,成立了非营利性组织 AI4All,将学科所缺少的年轻人——包括女孩、有色人种和贫困地区的孩子带进斯坦福大学和加州大学伯克利分校的校园。

如今 AI4All 正在逐渐壮大,目前已经能在六所学校举办夏令营。(去年新成立的卡内基梅隆大学夏令营共接到 20 个名额的 900 份申请。)一名 AI4All 的学生在研究如何利用计算机视觉检测眼部疾病。另一名学生用人工智能编写了一个对 911 呼叫紧急程度进行排序的程序:她的奶奶因为救护车没有及时赶到而不幸去世。这似乎说明,个人观念确实会影响到人工智能的未来。

入职谷歌,卷入争议

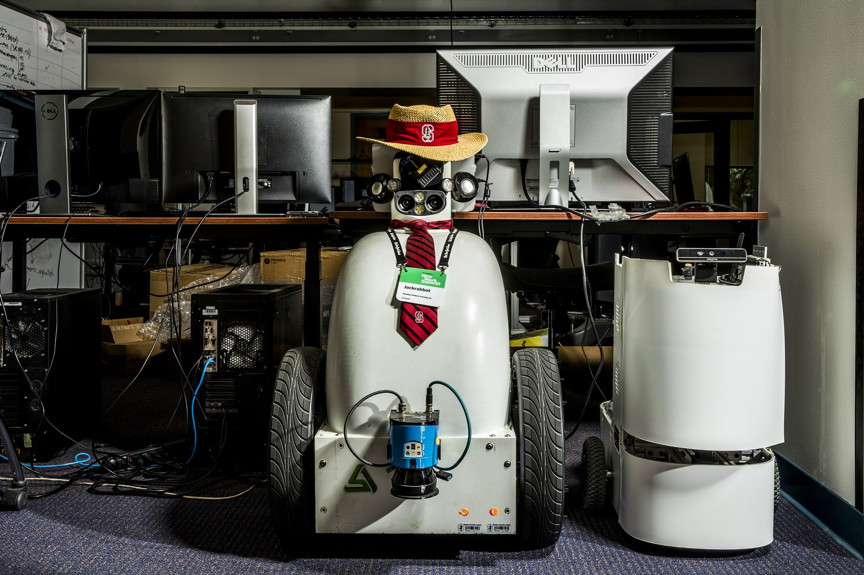

在斯坦福大学管理了三年人工智能实验室后,李飞飞在 2016 年学术休假,2017 年 6 月成为谷歌企业计算业务谷歌云(Google Cloud)的人工智能首席科学家。

李飞飞希望对整个行业的运作情况有所了解,看看客户急于开发新工具的需求并是否会改变自己跨学科研究的范围。脸书、谷歌、微软等公司向人工智能投入了大笔资金,希望能在自己的业务中用上这项技术。公司的数据通常比大学更多、更好。对研究人工智能的人来说,数据就是燃料。

最初的经历多姿多彩:她见识了那些对自己所研究的科学有实际需求的公司;带领小组推出了面向公众的人工智能工具,使大家无需编写代码就能创建机器学习算法;在中国开设了新实验室,改进人工智能以便用于医疗保健;还在达沃斯世界经济论坛(World Economic Forum in Davos)上发表了讲话,与国家元首和流行歌手近距离接触。

但私营公司的工作也带来了新的令人不安的压力。去年春天,谷歌与美国国防部签订了 Maven 项目,受到大众抨击,李飞飞也被卷入此事。该项目用人工智能分辨可让无人机瞄准攻击的视频图像,谷歌给出的说法是“使用人工智能进行低分辨率物体识别”,“最终目的是拯救生命”。但许多员工反对将他们的工作用在军用无人机上。约 4000 名员工集体签署了请愿书,要求“出台明确政策,确保谷歌及其承包商永远不会建立战争技术”。几名工人辞职以示抗议。

虽然李飞飞并没有直接参与其中,但她所在的部门负责管理 Maven 项目,她也因此成为公众非议的中心。这与她在公众面前布道者的形象大相径庭,让人感到迷惑。事实上,在事件发酵之前她认为这项技术“完全无害”;她没想到会迎来员工的抗议。

但李飞飞也确实找到了问题爆发的原因所在:“事情本来不是这样。这是由于当下对我们的责任、人工智能的力量,以及硅谷需要参与的对话有一种集体紧迫感。Maven 项目恰恰是这样一个汇聚点。”“不作恶”不再是一个足够强硬的立场。

这场争议以谷歌宣布不会续签 Maven 合同告终。包括李飞飞在内的谷歌科学家和管理人员编写了(公共)指导方针,承诺谷歌将把人工智能研究的重点放在为社会谋福利的技术上,避免在工具中引入偏见,避免最终可能会对人类造成伤害的及技术。

李飞飞一直准备回到斯坦福大学,但她认为通过这些指导方针至关重要。她说,指导方针正式推出的那天是她一年中最快乐的一天之一。

人工智能的伦理

七月下旬,李飞飞打电话问我:“你知道香农·瓦罗(Shannon Vallor)的事了吗?”。

瓦罗是圣克拉拉大学(Santa Clara University)的一名哲学家,专门研究新兴科技的哲学伦理问题,她刚刚签约成为谷歌云的咨询伦理学家。李飞飞之前一直在为此事努力,在华盛顿作证时还引用了瓦罗的话:“没有独立的机器价值观。机器价值观其实是人的价值观。”这一任命并非没有先例。其他公司也已经针对人工智能的用途和使用者设置了限制。2016 年微软成立了内部道德委员会。该公司表示,由于董事会提出的道德问题,他们拒绝了某些潜在客户的业务。委员会还限制了人工智能技术的使用范围,例如禁止在某些应用中使用面部识别。

但是代表公司内部讨论伦理问题,就好比是狐狸在看管鸡舍。我们七月份打电话的时候,李飞飞就知道她要离开谷歌了,两年的学术休假即将结束。很多流言猜测她会在 Maven 项目事件后辞职,但她说自己回到斯坦福是因为不想放弃学术地位。电话那头的李飞飞听起来有些疲惫。在谷歌过了一个动荡的夏天之后,她参与编写的道德准则据自己说是“隧道尽头的光明”。

她很希望能在斯坦福开始新项目。2018 年秋天,她和前斯坦福大学院长约翰·埃切门迪(John Etchemendy)宣布建立一个学术中心,进行人工智能和人文学科、硬科学、设计研究等的跨学科研究。她说:“作为一门新兴科学,人工智能还未在全部学科领域中吸纳人文和社会科学家。”长久以来人们认为这些学科和人工智能领域毫不沾边, 但李飞飞坚信这些会成为人工智能未来发展的关键。

李飞飞基本还是乐观的。在六月的听证会上,她对议员们说:“我深入思考过那些目前对人类有危险的、有害的工作,从灭火到搜救,再到灾后重建。” 她认为我们不应该只是尽可能避免把人类置于危险的境地,还应该考虑如何用技术帮助人类完成危险的工作。

当然,某个机构的一个程序,无论多好都很难改变整个领域。但李飞飞坚信她必须要尽己所能训练不同背景的研究人员像伦理学家一样思考,坚守原则而不是一味追求利润。

在电话中我问李飞飞,是否可以用其它方式来发展人工智能,避开目前我们遇到的这些问题。她回答:“我觉得这很难说,科学进步和创新来自于繁琐的工作、大量试验和频繁试错。我们认识到这种偏见也花了一段时间。我用了六年才真正清醒,意识到‘天哪,我们正一步步走向危机。’”

在国会山的时候,李飞飞说道:“作为一名科学家,我对人工智能科学的新生程度感到谦卑。它是一门只发展了 60 年的科学。与那些给人类带来美好生活的物理学、化学、生物学等经典科学相比,人工智能要发挥潜力、充分造福人类,还有很长的路要走。通过适当的指引,人工智能将使生活更美好。但如果缺乏指引,这项技术将进一步扩大财富鸿沟,增加科技的排外性,我们几代人努力消除的偏见也会因此被加强。”

李飞飞让我们相信,现在正是一项技术显示其影响的关键时刻。

来源:微信公号“科研圈”

“AI达摩”齐聚世界人工智能大会

受武器化争议影响,传谷歌AI首席科学家李飞飞或离职

谷歌在中国的AI投资会成功吗?

李飞飞最新访谈:我每天都在对AI的担忧中醒来

谷歌CEO:AI虚假内容说明监管必要性

Silvio/李飞飞组开源大型室内场景的模拟环境iGibson

李飞飞团队加入AI抗疫:家用监控系统,可以远程反馈新冠症状

继无人车后,谷歌开始协助劳斯莱斯来训练他们的自动驾驶轮船AI系统

李飞飞最新访谈:希望AI领域泡沫尽快消散,尤其是医疗部分

谷歌AI成“人”了?专家称“还远得很”